2018-12-25 02:22

Публикуем лонгрид по ещё одной презентации с прошедшего VK Hackathon. Руководитель прикладных исследований «ВКонтакте» Павел Калайдин рассказывает о работе искусственного интеллекта и о том, как его обмануть.

Распознавание

Все встречали изображения с оптическими иллюзиями, когда человек видит не то, что на них нарисовано. Точно также работают алгоритмы, когда пытаются распознать что-либо.

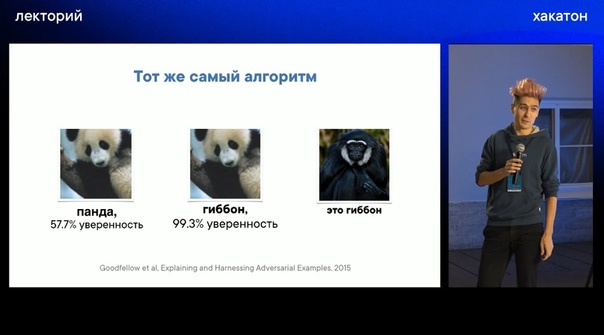

Например, есть картинка с изображением панды. Большинство детектеров, которые определяют объекты на фотографиях, будут уверены примерно на 60 %, что на изображении панда. Но если сделать похожее изображение с небольшим отличием в кодировании цветов, то алгоритм будет уверен с большей уверенностью, что это это гиббон, чем в первом случае.

Ещё одним примером можно выделить атаку на дорожные знаки: на знак STOP прикрепляли стикеры, а машина распознавала его как ограничение скорости.

Область, о которой ведётся речь в презентации, называется «Безопасность искусственного интеллекта» (ИИ), и сейчас активно ведутся исследования по ней.

В начале создания ИИ считался способом для решения задач, с которыми не может справиться человек, но решение которых может закодить. Например, отправить ракеты в космос. Со временем стало понятно, что, наоборот, ИИ — это решение задач, которые человек знает как сделать, но не может это закодить. Например, распознавание лица человека.

Для создания ИИ используется машинное обучение, которое берёт некоторые данные и находит их в них паттерн.

Считается, что ИИ самообучается, но это не совсем так. Алгоритм обучается на основе полученных данных, и качество его работы будет зависеть от опыта работы с данными.

Например, задача по определению хэштега по фотографии.

Обучение происходит так: имеется нейронная сеть, которая является функцией, содержащая какие-то веса. И в зависимости от ошибки эти веса меняются.

Как происходит обучение?

Пример, как это работает:

Довольно распространена практика брать уже готовую нейросеть, дообучать её и использовать под свои задачи.

Всё началось с автоматизации борьбы со спамом, и спамеры пытаются пытаются обойти фильтры. Одними из первых атак на машинное обучение являлись попытки обойти фильтры для отправки спама.

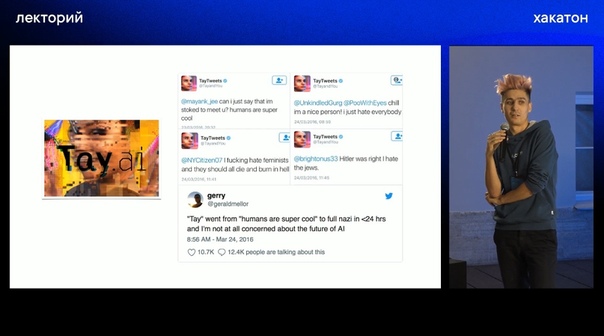

Примером атак, может быть бот Microsoft — Tay, запущенный в Twitter. Он общался с пользователем, собирал от них информацию и тем самым обучался. Вскоре бот был отключен, так как он начал нецензурно выражаться.

Примеры того, как пытаются перехитрить фильтры «ВКонтакте»:

Один из примеров, где использовался ИИ в соцсети — памятная акция «Мирное небо»:

Adversarial machine learning — это задача, когда создаётся машинное обучение, которое нападает на другое машинное обучение, или же, наоборот, защищается от него.

Adversarial Example — это специальные примеры данных, которые показывают алгоритму, чтобы он заведомо ошибся.

Виды атак:

Для атак можно использовать выходы из уже имеющейся модели и обучить свою модель.

Изображения

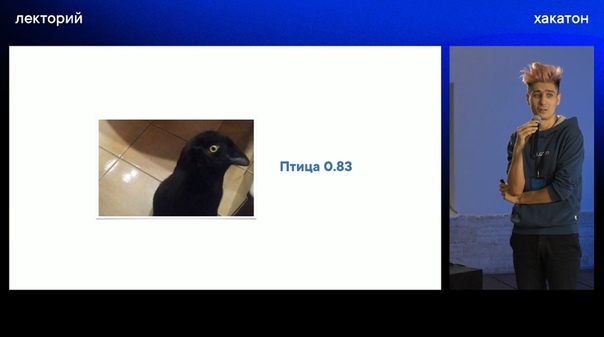

Обмануть алгоритм можно, использовав примеры, которые неизвестны модели. Но лучшим способом обхода ИИ является максимальное мимикрирование изображения под оригинал.

Примеры атак с помощью добавления шума:

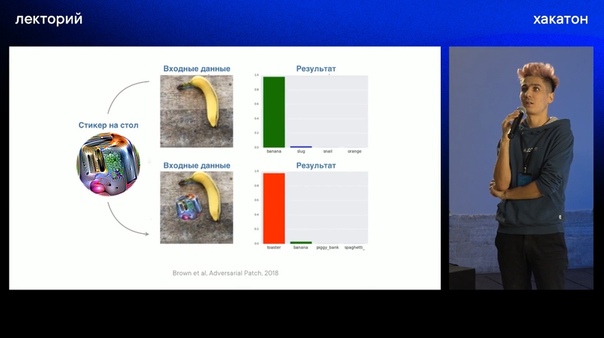

Примеры атак с помощью добавления стикера:

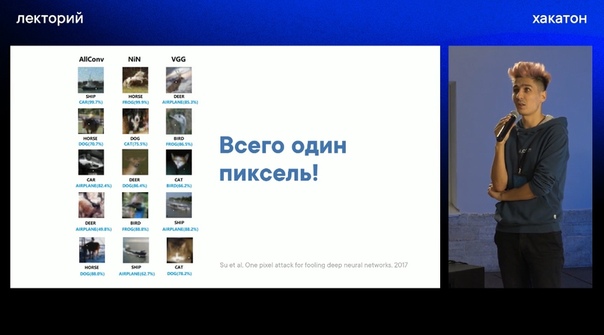

Примеры атак с помощью изменения пикселя:

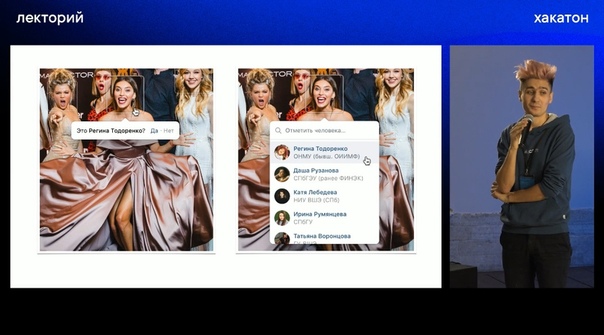

Также атаки производятся и на алгоритмы распознавания лиц:

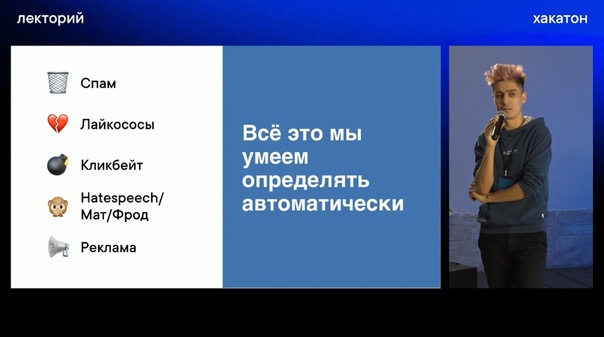

Что может автоматически определять система «ВКонтакте» в текстах:

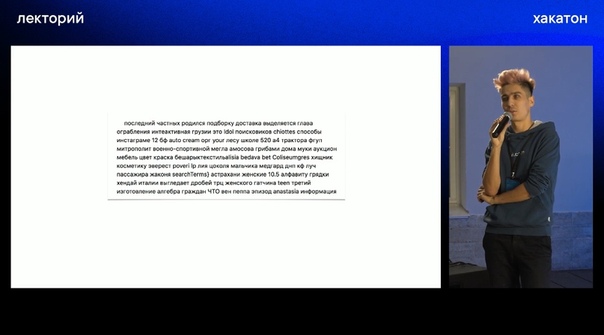

Пример поискового спама:

Пример, как обмануть алгоритм определения токсичности комментариев:

На каждую защиту можно придумать множество атак, поэтому эффективной защитой является как можно максимально усложнить задачу.

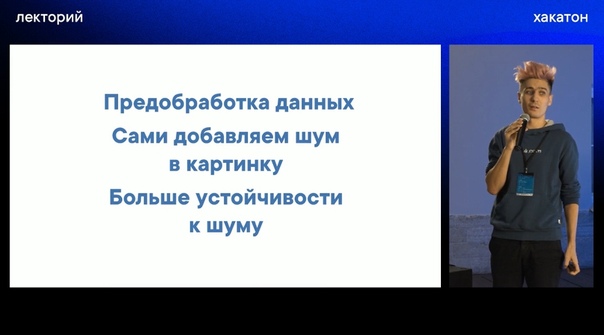

Как усложнить задачу:

Крутой концепцией является Defensive distillation, для которой используются тёмные знания.

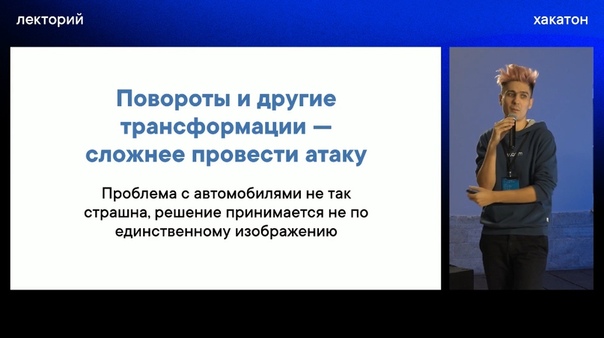

Что ещё может усложнить работу проводимых атак:

Умение атаковать помогает найти способы защиты модели.

Пример атак «ВКонтакте» — переформулировать вопрос, ответ на который боты не смогут найти в поисковике.

Детектер думает, что это птица:

Вот и всё!

Посмотреть полную презентацию можно здесь:

Автор: Лена ГамельКорректор: Арсений Метелев

Источник: m.vk.com

|

Привет всем

Кибенематика - математическая кибернетика с намеком на отсыл к едреней фене__(АБС)__

понедельник, 24 декабря 2018 г.

Как обмануть искусственный интеллект?

Подписаться на:

Комментарии к сообщению (Atom)

Комментариев нет:

Отправить комментарий